نکات برجسته کلیدی

- Robots.txt ابزاری قدرتمند برای مدیریت رفتار موتور جستجو در وب سایت ها است.

- robots.txt تمام موتورهای جستجو را از خزیدن سایت شما مجاز نمی کند.

- استفاده نادرست از Robots.txt می تواند به SEO آسیب برساند و دوباره به سرعت مجدد پس از تغییر.

- برای امنیت یا محتوای خصوصی ، از نصب حفاظت از رمز عبور از تکیه بر بخشنامه Disallow استفاده کنید.

- به طور منظم حسابرسی Robots.txt تضمین می کند که آن را برای دید موتور جستجو بهینه می کند.

مقدمه

یک برند مشهور تجارت الکترونیک یک بار آن را در یک کابوس سئو پیدا کرد. یک شبه ، از نتایج جستجوی Google ناپدید شد و منجر به افت ناگهانی ترافیک و درآمد ارگانیک شد.

پس از ساعاتی از عیب یابی ناخوشایند ، مقصر کشف شد – روبات های گمراه کننده. این یک خط دارای موتورهای جستجوگر مسدود شده از خزنده از خزیدن در کل سایت بود و آن را برای مشتریان بالقوه نامرئی می کند.

Robots.txt مجاز به همه دستورالعمل ابزاری قدرتمند است. اما اگر به طور نادرست مورد استفاده قرار گیرد ، رتبه های جستجوی شما را خراب می کند ، مجدداً مجدداً تکرار می شود و باعث آسیب قابل توجهی در سئو می شود.

بنابراین ، دقیقاً چه چیزی همه DOS را مجاز نمی کند؟ وقتی از آن استفاده می شود یا از آن اجتناب می شود؟ در این مقاله ، همه چیز را در مورد روبات ها بررسی خواهیم کرد. txt همه را مجازات نمی کنیم.

پرونده robots.txt چیست؟

یک فایل Robots.txt یک فایل متنی ساده است که در فهرست دامنه ریشه وب سایت شما واقع شده است. این تصمیم می گیرد که رباتهای موتور جستجو چه چیزی را وارد می کنند و در کدام مناطقی که مجاز به کشف یا ضبط هستند. این پرونده از پروتکل محرومیت روبات ها ، همچنین به عنوان استاندارد محرومیت روبات ها نیز شناخته می شود. این مجموعه ای از دستورالعمل ها است که موتورهای جستجوگر مختلف هنگام خزیدن وب سایت ها از آن پیروی می کنند.

بدون یک پرونده روبات به خوبی تنظیم شده ، Google Bots می تواند آزادانه پرسه بزند و همه چیز را نمایه می کند. این ممکن است شامل صفحات شما در نتایج جستجو مانند صفحات سرپرست ، محتوای تکراری یا محیط آزمایش باشد.

توجه: Google محدودیت اندازه ۵۰۰ KIB را برای پرونده های Robots.txt اعمال می کند. هر محتوای بیش از حداکثر اندازه پرونده نادیده گرفته می شود.

می توانید با استفاده از افزونه Yoast SEO یا پرونده های سرور وب سایت خود ، فایل Robots.txt خود را ایجاد و تغییر دهید. کنسول جستجوی Google همچنین بینش مفیدی را برای مدیریت آسان فایل Robots.txt ارائه می دهد.

همچنین بخوانید: چگونه Google را از فهرست بندی اضافه کردن به صفحه وردپرس سبد خرید با استفاده از SEO YOAST حذف کنیم

نمونه هایی از پرونده های Howes.txt کار می کنند

Robots.txt بسته به نحوه دسترسی به رباتهای موتور جستجو ، قوانین مختلفی دارد. در اینجا چند مثال رایج آورده شده است:

مثال ۱: اجازه می دهد همه رباتها به کل وب سایت دسترسی پیدا کنند

User-agent: *

Disallow:چه کاری انجام می دهد:

- “کاربر-عامل: *” همه رباتهای موتور جستجو (Googlebot ، Bingbot و غیره) می توانند به سایت دسترسی پیدا کنند.

- میدان “خالی از مجازات” به معنای هیچ محدودیتی نیست و رباتها نمی توانند همه چیز را خزنده کنند.

چه موقع از آن استفاده کنید: اگر می خواهید دید کامل موتور جستجو برای کل وب سایت خود داشته باشید.

مثال ۲: عدم دسترسی به همه رباتها از دسترسی به یک فهرست خاص

User-agent: *

Disallow: /private-directory/چه کاری انجام می دهد: تمام ربات های موتور جستجو را از دسترسی به هر نوع “/مستقیم/مستقیم/” مسدود می کند.

چه موقع از آن استفاده کنید: اگر می خواهید مناطق حساس مانند پانل های سرپرست یا داده های محرمانه را پنهان کنید.

مثال ۳: اجازه دادن به Googlebot در حالی که دیگران را از یک فهرست جدا نمی کند

User-agent: Googlebot

Disallow: /images/

User-agent: *

Disallow: /private-directory/چه کاری انجام می دهد:

- GoogleBot نمی تواند به / تصاویر / فهرست ها دسترسی پیدا کند.

- همه ربات های دیگر نمی توانند به /هدایت خصوصی دسترسی پیدا کنند /.

چه موقع از آن استفاده کنید: اگر مجبور هستید ربات های Spectification را کنترل کنید ، Soch به عنوان اجازه دهید Google در حالی که مسدود می شود ، برخی از سایت های خود را خزید.

مثال ۴: مکان نقشه سایت XML خود را مشخص کنید

User-agent: *

Disallow:

Sitemap: https://www.[yourwebsitename].com/sitemap.xmlچه کاری انجام می دهد:

- امکان دسترسی کامل به رباتهای موتور جستجو را فراهم می کند.

- به موتورهای جستجو می گوید که مکان XML را پیدا می کنند و به آنها کمک می کند تا صفحات را به طور کارآمد نشان دهند.

چه موقع از آن استفاده کنید: اگر می خواهید موتورهای جستجو به راحتی نقشه سایت خود را پیدا و خزنده کنند.

همچنین بخوانید: نحوه ایجاد یک نقشه سایت وردپرس

تفاوت بین Robots.txt در مقابل روبات های متا در مقابل X-Robots-Tag

در حالی که Robots.txt ، روبات های متا و X-Robots نحوه مشاهده محتوای شما را با محتوای خود کنترل می کنند ، آنها به صورت متفاوتی خدمت می کنند.

- robots.txt: از خزیدن جلوگیری می کند ، اما در صورت پیوند در جای دیگر ، صفحه هنوز در نتایج جستجو ظاهر می شود.

- برچسب روبات های متا: به طور مستقیم نشان دهنده نمایه سازی و خزیدن صفحات جداگانه است.

- X-Robots-Tag: نمایه سازی پرونده های غیر HTML مانند PDF ، تصاویر و فیلم ها را کنترل می کند.

| نشان | robots.txt | برچسب های روبات متا | دارای عکسبرداری از روتس ایکس |

| محل | دایرکتوری ریشه (/robots.txt) | بخش یک صفحه وب | پاسخ هدر HTTP |

| کنترل | کل بخش های یک سایت | نمایه سازی و خزیدن صفحات خاص | نمایه سازی پرونده های غیر HTML |

| نمونه | مجازات: /خصوصی / | X-Robots-Tag: Noindex | |

| تأثیر بر سئو | رباتها را از خزیدن متوقف می کند ، در صورت اتصال در جای دیگر ، از نمایه سازی جلوگیری نمی کند | مانع از فهرست بندی صفحه و ظاهر شدن در نتایج جستجو می شود | پرونده های غیر HTML فهرست بندی نمی شوند |

| بهترین استفاده | موتورهای جستجو را از کل دایرکتوری ها مسدود کنید | جلوگیری از صفحات خاص از Appage به نتایج جستجو | فهرست بندی PDF ها ، تصاویر و سایر پرونده ها را کنترل کنید |

۶ روبات مشترک

درک Robots.txt وقتی که قوانین اساسی آن را می دانید آسان تر است. تم های ساده به مدیریت نحوه عملکرد رباتهای موتور جستجو با وب سایت شما کمک می کند:

- کاربر-عامل: این قانون به BOT یا خزنده می گوید دستورالعمل های زیر مربوط به آن است.

- مجازات: این قانون به رباتها می گوید که از پرونده ها ، پوشه ها یا صفحات خاص در سایت خود بازدید نکنند که شامل عبارات منظم خاصی است.

- مجاز: این قانون ربات های خزنده برخی از پرونده ها ، پوشه ها یا صفحات را خزنده می کنند.

- نقشه سایت: این قانون موتورهای جستجو را به محل نقشه سایت XML وب سایت شما هدایت می کند.

- خزیدن: این قانون از رباتها می خواهد که سایت شما را آهسته تر خزنده کنند. اما همه موتورهای جستجو از این قانون پیروی نمی کنند.

- Noindex: این قاعده مستلزم رباتها است که برخی از صفحات یا قسمت های سایت شما را فهرست بندی نکنند. با این حال ، پشتیبانی Google از قانون Noindex در Robots.txt غیرقانونی است.

۱٫ دستورالعمل کاربر-عامل

قانون “کاربر عامل” برای پرونده robots.txt شما مهم است. این قوانین مربوط به آن است که قوانین مربوط به آن است. هر موتور جستجو یک نام منحصر به فرد به نام “عامل کاربر” دارد. به عنوان مثال ، خزنده وب Google خود را “GoogleBot” می نامد.

اگر می خواهید فقط GoogleBot را هدف قرار دهید ، بنویسید:

User-agent: Googlebotشما می توانید عوامل مختلف را به طور جداگانه تایپ کنید ، هر یک با قوانین خاص. همچنین می توانید از Wildcard “*” استفاده کنید تا ردیف ها برای همه نمایندگان کاربر اعمال شود.

۲٫ دستورالعمل روبات ها را مجازات کنید

قانون “مجازات” برای تصمیم گیری در مورد بخش های وب سایت شما باید از موتورهای جستجو پنهان شود. این قانون به رباتهای موتور جستجو می گوید که به پرونده ها ، پوشه ها یا صفحات خاص در سایت خود نگاه نکنند.

مسدود کردن دایرکتوری

به عنوان مثال ، می توانید از قانون “DISLAWALL” برای جلوگیری از ورود رباتها به منطقه مدیر وب سایت خود استفاده کنید:

User-agent: *

Disallow: /admin/این همه URL ها را با “/مدیر/” از همه ربات های موتورهای جستجو شروع می کند.

با استفاده از کارتهای وحشی

User-agent: *

Disallow: /*.pdf$با Wildcard '*' می توانید تمام پرونده های PDF را در وب سایت خود مسدود کنید. به یاد داشته باشید پس از ایجاد تغییرات ، پرونده robots.txt خود را بررسی کنید تا شما را در مورد مسدود کردن هرگونه وارد شده از سایت انجام دهید.

۳٫ اجازه دستورالعمل

“مجازات” دسترسی به مناطق خاصی از یک وب سایت را مسدود می کند ، جایی که دستورالعمل “اجازه” می تواند در مناطق مسدود شده استثنائاتی ایجاد کند. این کار همراه با “مجازات” است تا بتوانید به پرونده ها یا صفحات مشخصات دسترسی پیدا کنید ، حتی در صورت مسدود شدن کل دایرکتوری.

به دایرکتوری که دارای تصاویر است فکر کنید. اگر می خواهید تصاویر Google یک تصویر خاص را در آن کارگردان مشاهده کنند ، در اینجا نحوه انجام این کار می توانید این کار را انجام دهید:

User-agent: Googlebot-Image

Allow: /images/featured-image.jpg

User-agent: *

Disallow: /images/در این حالت ، شما ابتدا به GoogleBot -Image دسترسی دارید “برجسته -image.jpg”. سپس ، تمام ربات های دیگر را از فهرست “/تصاویر/” مسدود کنید.

۴٫ دستورالعمل نقشه سایت

دستورالعمل “نقشه سایت” به موتورهای جستجو می گوید که مکان XML خود را پیدا کنید. نقشه سایت XML پرونده ای است که تمام صفحات کلیدی در سایت شما را نشان می دهد. این امر باعث می شود موتورهای جستجو برای خزیدن و نمایه کردن محتوای شما آسانتر شوند.

افزودن سایت خود به پرونده robots.txt آسان است:

Sitemap: https://www.[yourwebsitename].com/sitemap.xmlحتماً “https: // www را تغییر دهید. [yourwebsitename].com/sitemap.xml 'به آدرس اینترنتی سایت واقعی خود. می توانید با استفاده از کنسول جستجوی Google ، sitmap خود را ارسال کنید. BUTOTING آن در پرونده robots.txt شما را تقویت می کند که همه موتورهای جستجو می توانند آن را پیدا کنند.

۵٫

دستورالعمل “Crawl-dlay” کنترل می کند که چگونه سریع موتورها وب سایت شما را خز می کنند. هدف اصلی آن این است که سرور YouB را بیش از حد شلوغ نگه دارید وقتی بسیاری از ربات ها سعی می کنند به طور همزمان به صفحات دسترسی پیدا کنند.

زمان “خزیدن” در ثانیه اندازه گیری می شود. به عنوان مثال ، این کد به Bingbot می گوید ۱۰ ثانیه صبر کند قبل از درخواست دیگری:

User-agent: Bingbot

Crawl-delay: 10وقتی Delas Crawl را تنظیم می کنید ، مراقب باشید. مدت زمان طولانی تاخیر می تواند نمایه سازی و رتبه بندی وب سایت شما باشد. این امر به ویژه در صورتی که سایت شما صفحات زیادی داشته باشد و به صورت تنظیم شده به روز شود ، صادق است.

توجه: Crawler Google ، GoogleBot ، Dosniet این مدیر. اما می توانید نرخ خزیدن را از طریق کنسول جستجوی Google تنظیم کنید تا از اضافه بار سرور جلوگیری شود.

همچنین بخوانید: نحوه تأیید مالکیت وب سایت در کنسول جستجوی Google

۶٫ دستورالعمل Noindex

دستور “Noindex” موتورهای جستجو را از ذخیره صفحات خاص از وب سایت شما متوقف می کند. اما اکنون ، Google به طور رسمی از این قانون پشتیبانی نمی کند.

برخی از تست ها “Noindex” را در Robots.txt هنوز هم می توانند کار کنند. اما IDA خوب نیست که به این روش وابسته باشد. در عوض ، می توانید از برچسب های متا روبات یا The the the استفاده کنید

چرا واردات Robots.txt برای SEO است؟

یک فایل روبات به خوبی تنظیم شده. TXT ابزاری قوی برای سئو است. این پرونده به این صورت است که گوگل و سایر موتورهای جستجوگر محتوای وب سایت خود را پیدا ، مرور و ضبط می کنند. به نوبه خود ، این مسئله تأثیر می گذارد که سایت شما به خوبی دیده می شود و رتبه بندی می شود.

۱٫ بودجه خزیدن را بهینه کنید

بودجه خزیدن تعداد صفحاتی است که GoogleBot در یک زمان خاص در وب سایت شما فهرست بندی می کند. اگر بودجه خزیدن خود را خوب بهینه کنید ، Google روی محتوای مهم شما تمرکز خواهد کرد.

شما می توانید از Robots.txt برای جلوگیری از بازدید Google از بازدید از صفحات غیرقانونی استفاده کنید و زمان بیشتری را در مورد محتوای ارزشمند خود جمع کنید.

۲٫ صفحات تکراری و غیر عمومی را مسدود کنید

محتوای تکراری یک مشکل شایع است که می تواند به سئو شما آسیب برساند. این موتورهای جستجو را گیج می کند و اقتدار وب سایت شما را تضعیف می کند.

با استفاده از Robots.txt ، می توانید دسترسی به صفحات تکراری مانند نسخه های PDF یا محتوای قدیمی را مسدود کنید. به این ترتیب ، موتورهای جستجو می توانند روی نسخه های اصلی و مهم صفحات شما متمرکز شوند.

همچنین بخوانید: محتوای تکراری چیست: چگونه می توان از آن استفاده کرد و از آن جلوگیری کرد

۳٫ منابع را مخفی کنید

مخفی کردن پرونده های CSS یا JavaScript از موتورهای جستجو ممکن است ایده خوبی برای بودجه خزیدن وب سایت شما به نظر برسد. اما اینطور نیست

موتورهای جستجو از این پرونده ها برای استفاده از صفحات خود استفاده می کنند و نحوه عملکرد وب سایت شما را درک می کنند. اگر این پرونده ها را مسدود کنید ، موتورهای جستجو ممکن است برای ارزیابی تجربه کاربر وب سایت شما تلاش کنند. این به رتبه های جستجوی شما آسیب می رساند.

نحوه استفاده از robots.txt همه را برای موتورهای جستجوگر مجاز نمی کند

می توانید با اضافه کردن “Robots.txt” در انتهای URL ، پرونده robots.txt سایت خود را بررسی کنید. به عنوان مثال ، https://www.bluehost.com/robots.txt. بیایید بررسی کنیم که چگونه می توانید فایل Robots.txt را با استفاده از مدیر فایل BlueHost پیکربندی کنید:

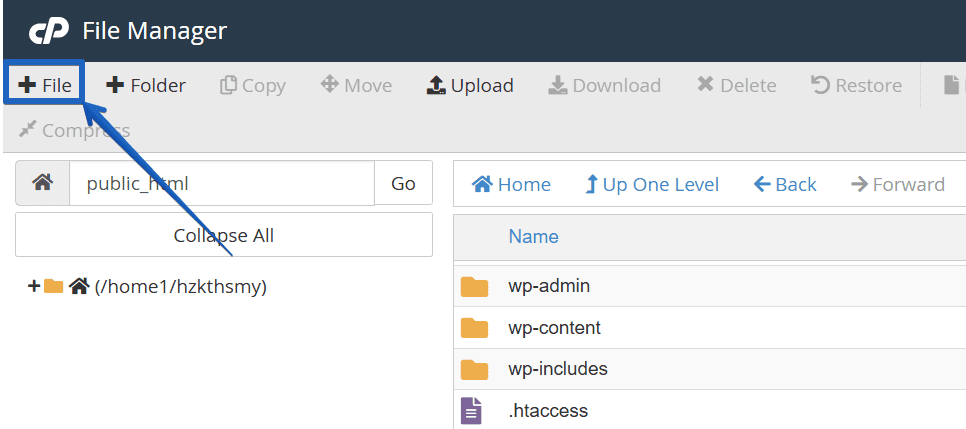

۱٫ به مدیر پرونده دسترسی پیدا کنید

- وارد مدیر حساب BlueHost خود شوید.

- در منوی سمت چپ به برگه “میزبانی” بروید.

- روی “مدیر فایل” در زیر “پیوندهای سریع” کلیک کنید.

۲٫ پرونده robots.txt را پیدا کنید

- در فهرست “مدیر پرونده” ، “Public_Html” را باز کنید ، که شامل پرونده های وب سایت شما است.

- در این فهرست به دنبال نام پرونده “Robots.txt” باشید.

۳٫ پرونده robots.txt را ایجاد کنید (وجود ندارد)

اگر پرونده Robots.txt ارائه نشده باشد ، می توانید آن را ایجاد کنید. در اینجا چگونه:

- روی دکمه “+ پرونده” در گوشه بالا سمت چپ کلیک کنید.

- پرونده جدید “robots.txt” را نامگذاری کنید. اطمینان حاصل کنید که در فهرست “/public_html” قرار داده شده است.

۴٫ پرونده robots.txt را ویرایش کنید

- بر روی پرونده “robots.txt” راست کلیک کرده و “ویرایش” را انتخاب کنید.

- یک ویرایشگر متن باز خواهد شد و به شما امکان می دهد Direcifififififififififififififififififififififififififififififififififififififififies شود.

۵٫ روبات ها را پیکربندی کنید.

برای کنترل نحوه سایت سایت ، می توانید Directififififififififififififififififififififififififififififififififififififififififififififififlififlift های خاص را به پرونده robots.txt می توانید اضافه کنید. این یک تنظیمات زیرمون است:

- موتورهای جستجوگر “All All” از دسترسی به کل سایت: برای جلوگیری از خزیدن همه ربات های موتور جستجو در هر قسمت از سایت خود ، خطوط زیر را اضافه کنید:

User-agent: *

Disallow: /این به همه نمایندگان کاربر (مشخص شده توسط ستاره *) می گوید که به هیچ صفحه ای در سایت خود دسترسی پیدا نکنند.

- موتورهای جستجو خاص را از یک پوشه خاص مجازات کنید: اگر ربات موتور جستجوی خاصی را از خزیدن یک دایرکتوری خاص دارید ، کاربر-Aent-Ant و فهرست را مشخص کنید:

User-agent: Googlebot

Disallow: /example-subfolder/این مثال ، ربات Google را از دسترسی به / نمونه / فهرست / دایرکتوری مسدود می کند.

- رباتهای “همه را مجازات کنید” از دایرکتوری های خاص: برای جلوگیری از همه رباتها از طرفداران مراقبت ، آنها را به شرح زیر ذکر کنید:

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /junk/این پیکربندی مانع از دسترسی همه نمایندگان کاربر به /CGI-BIN /، /TMP /و /ناخواسته /دایرکتوری ها می شود.

ملاحظات مهم قبل از استفاده از روبات ها.

این مهم است که چگونه و هنگامی که از “All All” در پرونده Robots.txt خود استفاده می کنید ، زیرا می تواند سایت سایت شما را ارائه دهد. این چند مورد است که باید قبل از استفاده از Robots.txt همه را در خاطر داشته باشید.

۱٫ هدف از پرونده robots.txt

قبل از تغییر پرونده robots.txt ، باید بدانید که برای آن چیست. پرونده Robots.txt این نیست که یک ابزار ایمنی باشد یا وب سایت خود را از هرگونه تهدید مخفی کنید. اگر محتوای حساس دارید ، بهتر است به جای استفاده از Robots.txt از روشهای قوی تری مانند محافظت از رمز عبور استفاده کنید.

۲٫ تأثیر بر حضور شاخص

استفاده از Robots.txt مجاز به همه می تواند به طور جدی بر نمایشگاه های وب سایت در موتورهای جستجو تأثیر بگذارد. هنگامی که بیت های موتور جستجو را از سایت خود متوقف می کنید ، آنها در نهایت صفحات شما را از فهرست آنها حذف می کنند. در نتیجه ، ترافیک شما از جستجوی Google به شدت کاهش می یابد.

۳٫ تأثیر بر سهام لینک

Link Equity (یا Link Juice) برای رتبه بندی خوب در SEO بسیار مهم است. هنگامی که وب سایت های قابل اعتماد به صفحات شما پیوند می خورند ، آنها برخی از اختیارات را به اشتراک می گذارند. اما شما از robots.txt استفاده می کنید تا موتور رباتها را مسدود کنید ، همچنین جریان سهام لینک را متوقف می کنید.

۴٫ خطر دسترسی عمومی

پرونده های robots.txt در دسترس عموم هستند. هرکسی می تواند ببیند بخشی از وب سایت شما از موتورهای جستجو محدود است. برای امنیت بهتر ، از احراز هویت سمت سرور ، فایروال ها ، روشهای مسدود کردن IP استفاده کنید یا محتوای حساس را در مدیران امن قرار دهید.

۵٫ از خطاهای نحوی خودداری کنید

یک اشتباه کوچک نحوی در پرونده robots.txt شما می تواند منجر به خزیدن ناخواسته شود. این ممکن است از دسترسی موتورهای جستجو به صفحات مهم یا عدم جلوگیری از مناطق ناخواسته جلوگیری کند.

برای جلوگیری از این امر ، نحو و ساختار خود را قبل از وارد کردن تغییرات ، دو برابر کنید. برای شناسایی هرگونه اشتباه می توانید از یک چکر نحوی آنلاین یا ابزار تست استفاده کنید.

۶٫ پرونده robots.txt را آزمایش کنید

آزمایش منظم کمک می کند تا تأیید کنید که سهواً محتوای ضروری را مسدود نمی کنید یا بخش های مهم سایت خود را محافظت نمی کنید. همچنین تضمین می کند که پرونده robots.txt شما تأثیر استراتژی SEO وب سایت شما باقی بماند.

همچنین بخوانید: نحوه بهینه سازی محتوا برای سئو در وردپرس

هر چند پایانی

Mastering Robots.txt یک مهارت کلیدی برای صاحبان وب سایت و SEO است. هنگامی که شما چگونه برای کار است ، می توانید موتورهای جستجوگر HALP را پیدا کنید که محتوای واردات خود را پیدا کنید. این می تواند به دید بهتر ، رتبه بندی جستجوی بالاتر و ترافیک ارگانیک بیشتر منجر شود.

اما با استفاده از robots.txt همه را با دقت انجام دهید. این می تواند در طولانی مدت تأثیرات عمده ای بر سئو شما داشته باشد. با دنبال کردن بهترین شیوه ها ، بررسی پرونده robots.txt خود را اغلب و به روزرسانی در موتورهای جستجو ، می توانید از robots.txt نهایت استفاده را ببرید. این به بهینه سازی وب سایت شما برای موفقیت کمک می کند.

متداول

“همه را مجازات کنید” در روبات ها. txt تمام ربات های موتور جستجو را از خزیدن هر قسمت از سایت خود مسدود می کند.

robots.txt به خزندگان وب کمک می کند تا درک کنند که کدام صفحات برای فهرست بندی هستند. این دیدگاه شما در جستجوی Google و رتبه بندی شماست.

استفاده از Robots.txt همه می تواند صفحات شما را از نتایج جستجو خارج کند ، و باعث از بین رفتن ترافیک و خسارت سئو می شود که زمان لازم برای بازپرداخت است.

بله ، استفاده از “مجاز بودن همه” می تواند به سئو شما آسیب برساند. این می تواند سایت شما را در Google و دید شما در کنسول جستجوی Google دشوار کند.

برای تماس با بخشنامه “مجازات همه”:

۱٫ “مجازات: /” را از پرونده robots.txt حذف کنید.

۲٫ پرونده به روز شده Robots.txt را در کنسول جستجوی Google ارسال کنید.

۳٫ برای کمک به موتورهای جستجو سریعتر صفحات را دوباره کشف کنید.

۴٫ کنسول جستجوی Google را برای خطاهای خزنده کنترل کنید.

نه ، روبات ها. بهتر است برای اطلاعات حساس از گزینه های امنیتی قوی مانند رمزهای عبور استفاده کنید.

پس از طراحی مجدد وب سایت خود ، جابجایی محتوا یا ایجاد هرگونه تغییر بزرگ در طرح سایت خود ، پرونده Robots.txt خود را بررسی و به روز کنید. اطمینان حاصل کنید که این با استراتژی فعلی SEO شما مطابقت دارد و SitMap XML شما به درستی در ارتباط است.

پست Robots.txt همه و تأثیر آن بر سئو چیست؟ برای اولین بار در وبلاگ BlueHost ظاهر شد.

منبع: https://www.bluehost.com/blog/robots-txt-disallow-all/