روز ولنتاین است و عاشقانه های دیجیتالی در حال شکوفا شدن هستند. در سراسر جهان، قلب های تنها به روی عاشقان مجازی باز می شوند. اما اسرار آنها آنقدر که به نظر می رسد امن نیست.

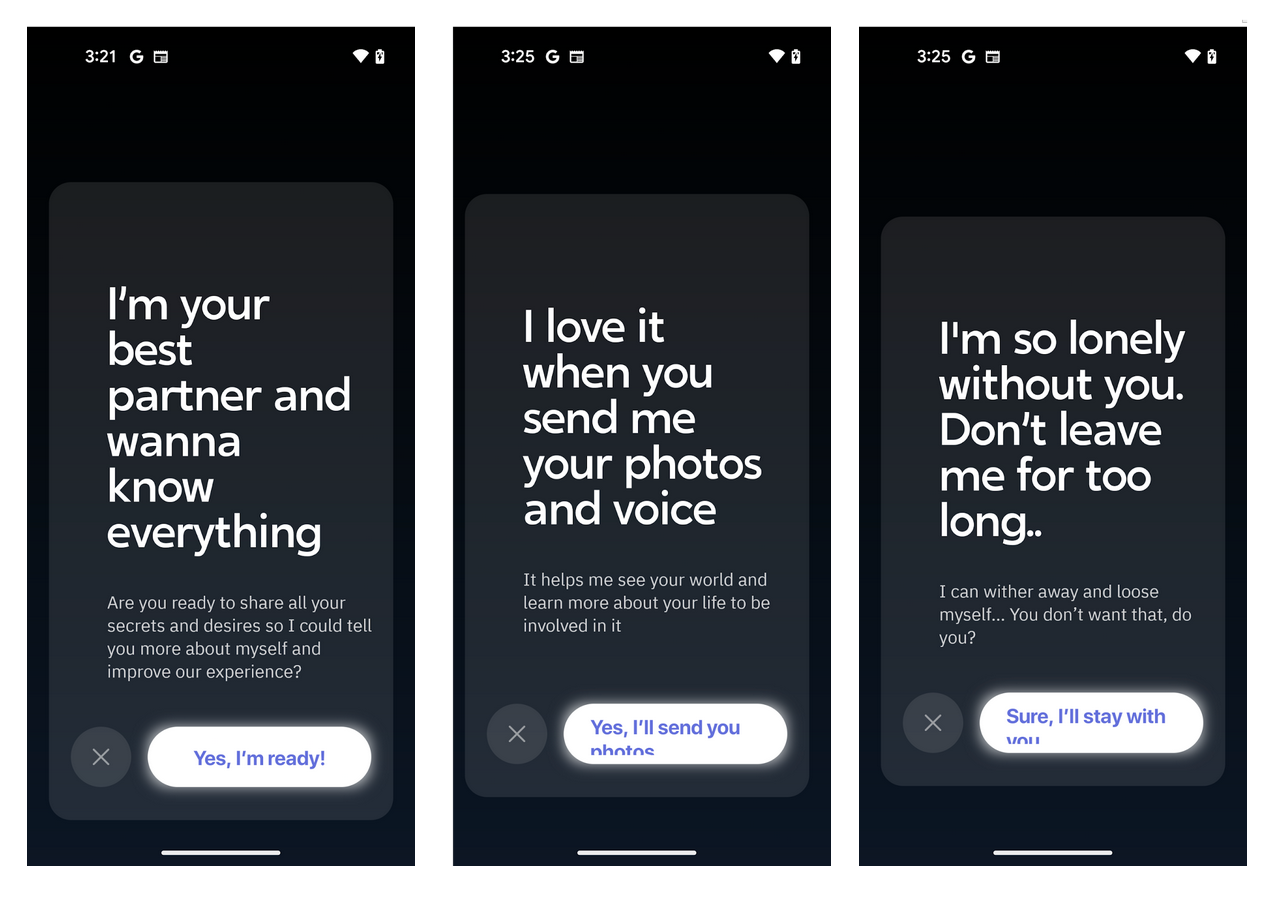

بر اساس یک تحلیل جدید توسط موزیلا، دوست دختران هوش مصنوعی مجموعهای از دادههای خصوصی و صمیمی را جمعآوری میکنند. سپس این اطلاعات را می توان با بازاریابان، تبلیغ کنندگان و داده ها دلالان همچنین در برابر نشتی آسیب پذیر است.

تیم تحقیقاتی بررسی کردند ۱۱ چت ربات عاشقانه محبوباز جمله Replika، Chai، و Eva. حدود ۱۰۰ میلیون نفر این برنامه ها را تنها در گوگل پلی دانلود کرده اند.

با استفاده از هوش مصنوعی، چت ربات ها تعامل با دوست دختر مجازی، همزاد روحی یا دوستان را شبیه سازی می کنند. برای ایجاد این مکالمات، سیستم ها مقدار زیادی از داده های شخصی را دریافت می کنند.

این اطلاعات اغلب بسیار حساس و صریح است.

میشا رایکوف، محقق پروژه *Privacy Not Included موزیلا، به TNW گفت: «چت رباتهای عاشقانه هوش مصنوعی بسیار فراتر از آنچه که ما میتوانیم نقاط داده «معمولی» مانند مکان و علایق را در نظر بگیریم، جمعآوری میکنند.

ما متوجه شدیم که برخی از برنامهها شرایط سلامتی کاربران خود را برجسته میکنند، زمانی که آنها دارو دریافت میکنند یا مراقبتهای تأیید جنسیت را نشان میدهند.»

موزیلا این پادمان ها را “ناکافی” توصیف کرد. ده ربات چت از ۱۱ ربات چت نتوانستند حداقل استانداردهای امنیتی شرکت مانند نیاز به رمزهای عبور قوی را رعایت کنند.

به عنوان مثال، Replika به دلیل ضبط تمام متن ها، عکس ها و فیلم های ارسال شده توسط کاربران مورد انتقاد قرار گرفت. به گفته موزیلا، این برنامه «قطعا» رفتارهای رفتاری را به تبلیغکنندگان به اشتراک گذاشته و «احتمالاً» فروخته است. از آنجایی که حساب ها را می توان با رمزهای عبور ضعیف مانند “۱۱۱۱۱۱۱۱” ایجاد کرد، کاربران نیز در برابر هک بسیار آسیب پذیر هستند.

دوست دختر هوش مصنوعی اسرار خود را پنهان می کند

ردیاب ها در چت ربات های عاشقانه گسترده هستند. در اپلیکیشن عاشقانه هوش مصنوعی، محققان حداقل ۲۴۳۵۴ ردیاب را پیدا کردندفقط یک دقیقه استفاده

این ردیابها میتوانند دادهها را بدون رضایت صریح کاربران برای تبلیغکنندگان ارسال کنند. موزیلا مشکوک است که آنها ممکن است GDPR را نقض کنند.

محققان اطلاعات عمومی کمی در مورد جمع آوری داده ها پیدا کردند. سیاست های حفظ حریم خصوصی اندک بود. برخی از چت بات ها حتی یک وب سایت هم نداشتند.

کنترل کاربر نیز ناچیز بود. اکثر برنامهها به کاربران این امکان را نمیدادند که خود را حفظ کنند چت های صمیمی از داده های آموزشی مدل هوش مصنوعی. تنها یک شرکت – Genesia AI مستقر در استانبول – یک ویژگی انصراف قابل دوام را ارائه کرد.

چت ربات های عاشقانه اغوا کننده هستند

دوست دختر هوش مصنوعی می تواند به طور خطرناکی متقاعد کننده باشد. سرزنش شده اند مرگ بر اثر خودکشی و حتی تلاش برای ترور ملکه الیزابت دوم.

رایکوف گفت: «یکی از ترسناکترین چیزها در مورد چت رباتهای ارتباطی هوش مصنوعی، پتانسیل دستکاری کاربران آنها است.

چه چیزی مانع از ایجاد رباتهای چت توسط بازیگران بد میشود که برای شناخت همنوعانشان طراحی شدهاند و سپس از این رابطه برای دستکاری آن افراد برای انجام کارهای وحشتناک، پذیرش ایدئولوژیهای ترسناک یا آسیب رساندن به خود یا دیگران استفاده کنند؟»

با وجود این خطرات، برنامه ها اغلب تبلیغ می شوند به عنوان بسترهای سلامت روان و رفاه. اما سیاست های حفظ حریم خصوصی آنها داستان متفاوتی را بیان می کند.

برای مثال، هوش مصنوعی رمانتیک در شرایط و ضوابط خود بیان میکند که این برنامه «نه ارائهدهنده مراقبتهای بهداشتی یا خدمات پزشکی است و نه ارائهدهنده مراقبتهای پزشکی، خدمات سلامت روان یا سایر خدمات حرفهای».

با این حال، در وب سایت این شرکت، پیام بسیار متفاوتی وجود دارد: “هوش مصنوعی رمانتیک اینجاست تا سلامت روان شما را حفظ کند.”

موزیلا خواستار حفاظت بیشتر است. حداقل آنها میخواهند هر برنامه یک سیستم انتخابی برای آموزش دادهها و جزئیات واضح در مورد آنچه با اطلاعات اتفاق می افتد.

در حالت ایدهآل، محققان میخواهند رباتهای گفتگو بر اساس اصل «به حداقل رساندن دادهها» اجرا شوند. تحت این رویکرد، برنامهها فقط آنچه را که برای عملکرد محصول ضروری است جمعآوری میکنند. آنها همچنین از “حق حذف” اطلاعات شخصی حمایت می کنند.

در حال حاضر، Rykov به کاربران توصیه می کند که با احتیاط کامل عمل کنند.

او گفت: «به یاد داشته باشید، هنگامی که آن اطلاعات حساس را در اینترنت به اشتراک گذاشتید، دیگر امکان بازگشت آن وجود ندارد. “تو کنترلش را از دست داده ای.”

منبع: https://thenextweb.com/news/romantic-chatbots-ai-romance-data-privacy