قدرتمندترین ابرکامپیوتر جهان از بیش از ۸ درصد از GPUهای مجهز به آن برای آموزش یک مدل زبان بزرگ (LLM) حاوی یک تریلیون پارامتر – قابل مقایسه با GPT-4 OpenAI استفاده کرده است.

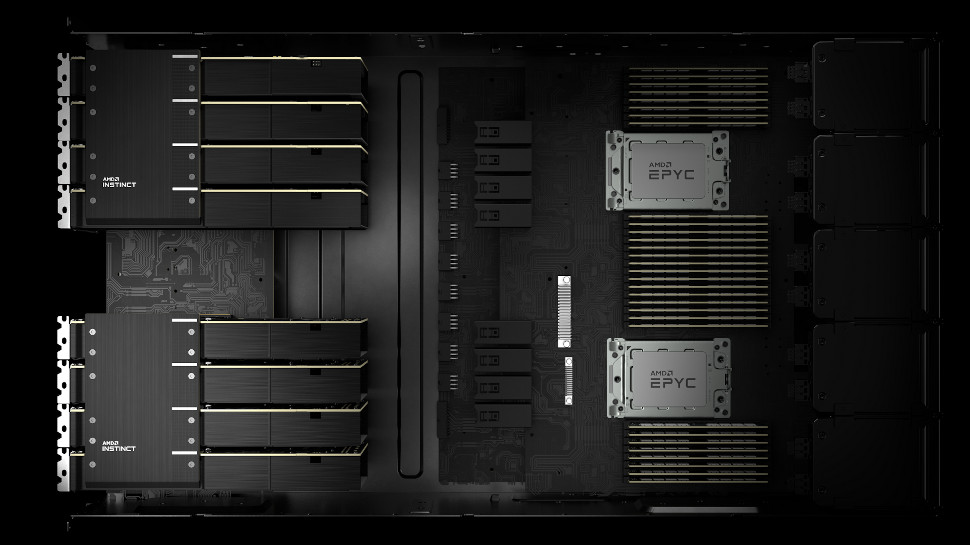

Frontier، مستقر در آزمایشگاه ملی Oak Ridge، از ۳۰۷۲ پردازنده گرافیکی AMD Radeon Instinct خود برای آموزش یک سیستم هوش مصنوعی در مقیاس تریلیون پارامتر استفاده کرد و از ۱۰۲۴ از این پردازندههای گرافیکی (تقریباً ۲٫۵٪) برای آموزش یک مدل پارامتری ۱۷۵ میلیاردی استفاده کرد. ، اساساً همان اندازه ChatGPT است.

به گفته محققان، برای دستیابی به این نتایج به حداقل ۱۴ ترابایت رم نیاز داشتند کاغذ آنهااما هر پردازنده گرافیکی MI250X تنها دارای ۶۴ گیگابایت VRAM بود، به این معنی که محققان باید چندین پردازنده گرافیکی را با هم گروه بندی می کردند. با این حال، این چالش دیگری را به شکل موازی معرفی کرد، به این معنی که با افزایش اندازه کلی منابع مورد استفاده برای آموزش LLM، مؤلفه ها باید بسیار بهتر و مؤثرتر ارتباط برقرار می کردند.

به کار انداختن قدرتمندترین ابرکامپیوتر جهان

LLM ها معمولاً روی ابررایانه ها آموزش نمی بینند، بلکه در سرورهای تخصصی آموزش دیده اند و به پردازنده های گرافیکی بسیار بیشتری نیاز دارند. به عنوان مثال، ChatGPT بر روی بیش از ۲۰۰۰۰ پردازنده گرافیکی آموزش دیده است TrendForce. اما محققان میخواستند نشان دهند که آیا میتوانند با استفاده از تکنیکهای مختلفی که توسط معماری ابررایانه ممکن شدهاند، یک ابر رایانه را بسیار سریعتر و مؤثرتر آموزش دهند.

دانشمندان از ترکیبی از موازی سازی تانسور – گروه هایی از پردازنده های گرافیکی که قطعات یک تانسور را به اشتراک می گذارند – و همچنین موازی خط لوله – گروه هایی از GPU هایی که اجزای مجاور را میزبانی می کنند، استفاده کردند. آنها همچنین از موازی سازی داده ها برای مصرف همزمان تعداد زیادی توکن و مقدار بیشتری از منابع محاسباتی استفاده کردند. اثر کلی دستیابی به زمان بسیار سریعتر بود.

برای مدل پارامتر ۲۲ میلیاردی، آنها به حداکثر توان عملیاتی ۳۸٫۳۸٪ (۷۳٫۵ TFLOPS)، ۳۶٫۱۴٪ (۶۹٫۲ TFLOPS) برای مدل پارامتری ۱۷۵ میلیارد و ۳۱٫۹۶٪ حداکثر توان (۶۱٫۲ TFLOPS) برای مدل ۱-trill رسیدند. .

آنها همچنین به ۱۰۰% راندمان مقیاس ضعیف، و همچنین ۸۹٫۹۳% عملکرد مقیاس بندی قوی برای مدل ۱۷۵ میلیاردی، و عملکرد مقیاس بندی قوی ۸۷٫۰۵% برای مدل پارامتر ۱ تریلیون دست یافتند.

اگرچه محققان در مورد منابع محاسباتی مورد استفاده و تکنیکهای درگیر صحبت میکردند، اما از ذکر بازههای زمانی مربوط به آموزش LLM به این روش غافل شدند.

TechRadar Pro از محققان زمانبندی خواسته است، اما آنها در زمان نگارش پاسخی ندادهاند.

بیشتر از TechRadar Pro

منبع: https://www.techradar.com/pro/most-formidable-supercomputer-ever-is-warming-up-for-chatgpt-5-thousands-of-old-amd-gpu-accelerators-crunched-1-trillion-parameter-models