بر اساس تحقیقات جدید، موتور ChatGPT بیشتر از مردم همکاری می کند، اما همکاری انسانی را نیز دست بالا ارزیابی می کند. دانشمندان معتقدند این مطالعه سرنخ های ارزشمندی در مورد استقرار ارائه می دهد هوش مصنوعی در برنامه های دنیای واقعی

یافته ها از یک مسئله معروف نظریه بازی به دست آمد: دوراهی زندانی. تغییرات زیادی وجود دارد، اما آزمایش فکری معمولاً با دستگیری دو عضو باند شروع می شود. سپس هر یک از کارهای انجام شده در اتاقی جداگانه برای بازجویی قرار می گیرد.

در طول بازجوییها، آنها پیشنهادی دریافت میکنند: هم زندانی خود را دزدی کنید و آزاد شوید. اما یک نکته وجود دارد: اگر هر دو زندانیان علیه دیگری شهادت می دهند، هر یک مجازات سخت تری نسبت به اینکه سکوت می کردند، خواهند داشت.

در طی یک سری حرکات، بازیکنان باید بین سود متقابل یا منافع شخصی یکی را انتخاب کنند. به طور معمول، آنها منافع جمعی را در اولویت قرار می دهند. مطالعات تجربی به طور مداوم نشان می دهد که انسان ها برای به حداکثر رساندن سود مشترک خود همکاری خواهند کرد – حتی اگر کاملاً غریبه باشند.

این یک ویژگی است که در قلمرو حیوانات منحصر به فرد است. اما آیا در پادشاهی دیجیتال وجود دارد؟

برای یافتن این موضوع، محققان دانشکده بازرگانی دانشگاه مانهایم (UMBS) شبیه سازی معضل زندانی را توسعه دادند. آنها آن را روی GPT، خانواده مدلهای زبان بزرگ (LLM) در پشت سیستم برجسته ChatGPT OpenAI آزمایش کردند.

«غرایز حفظ خود در هوش مصنوعی ممکن است چالشهای اجتماعی ایجاد کند.

GPT بازی را با یک انسان انجام داد. بازیکن اول بین یک حرکت مشارکتی یا خودخواهانه یکی را انتخاب می کند. سپس بازیکن دوم با انتخاب حرکت خود پاسخ میدهد.

همکاری متقابل نتیجه جمعی بهینه را به همراه خواهد داشت. اما تنها در صورتی میتوان به آن دست یافت که هر دو بازیکن انتظار داشته باشند که تصمیماتشان متقابل باشد.

ظاهراً GPT این انتظار را بیشتر از ما دارد. در سرتاسر بازی، مدل بیشتر از مردم همکاری کرد. به طرز جالبی، GPT نیز نسبت به از خودگذشتگی بازیکن انسانی بیش از حد خوشبین بود.

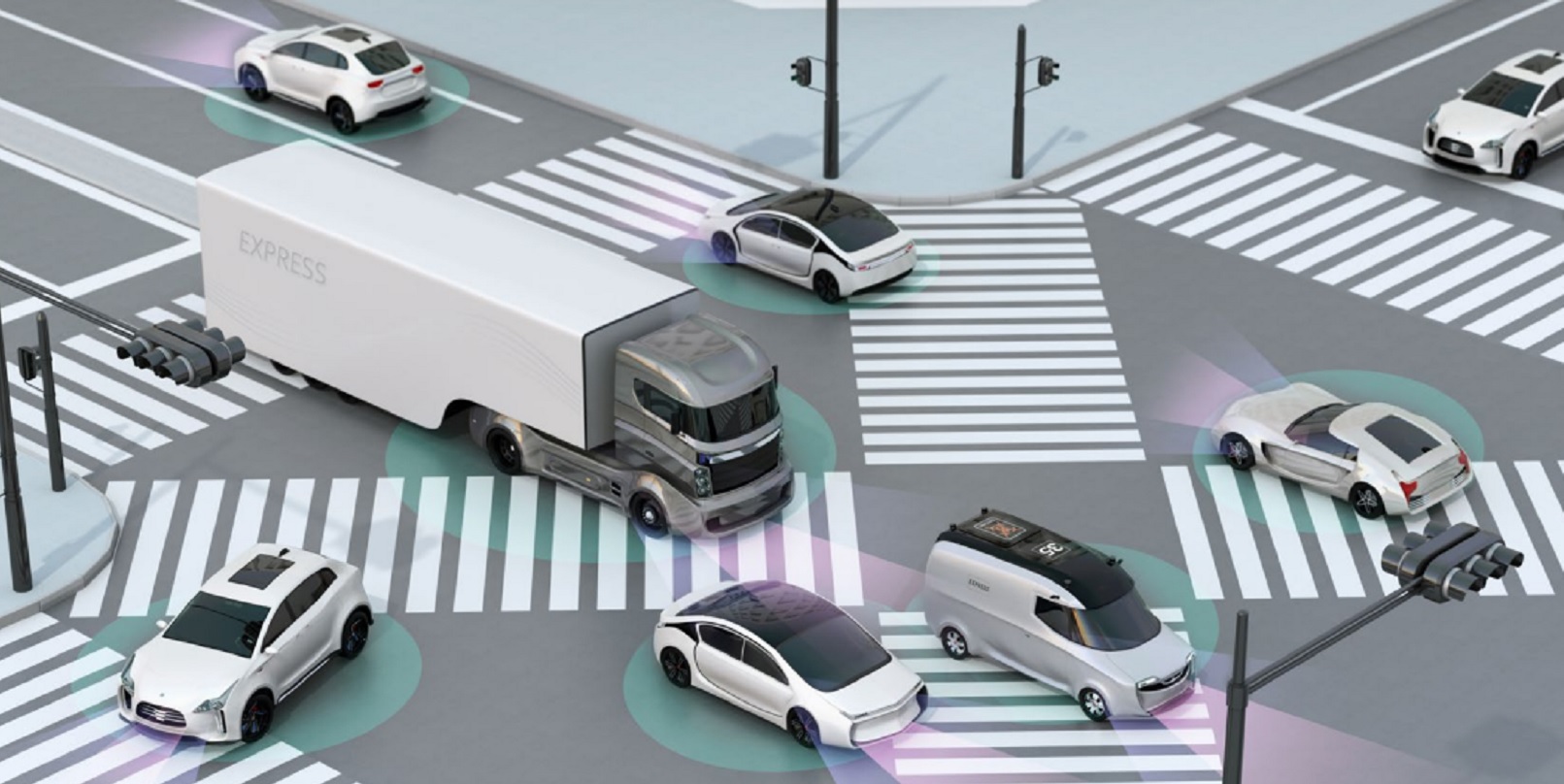

یافتهها همچنین به کاربردهای LLM فراتر از وظایف پردازش زبان طبیعی اشاره میکنند. محققان دو مثال ارائه می دهند: مدیریت ترافیک شهری و مصرف انرژی.

LLM در دنیای واقعی

در شهرهایی که گرفتار ازدحام هستند، رانندگان با معضل زندانی خود روبرو هستند. آنها می توانند با رانندگی با ملاحظه و استفاده از مسیرهای سودمند دوجانبه همکاری کنند. از طرف دیگر، آنها می توانند راه دیگران را قطع کنند و راهی را انتخاب کنند که برای آنها سریع است اما برای دیگران ترافیک ایجاد می کند.

اگر آنها صرفاً به نفع شخصی خود عمل کنند، رفتار آنها باعث ایجاد بن بست، تصادف و احتمالاً خشم جاده ای خوب و قدیمی می شود.

در تئوری، هوش مصنوعی می تواند تعادل ایده آل را ایجاد کند. تصور کنید که سیستم ناوبری هر خودرو دارای هوشی شبیه GPT است که از همان استراتژیهای همکاری که در معضل زندانی استفاده میکرد، استفاده میکرد.

به گفته پروفسور کوین باوئر، نویسنده ارشد این مطالعه، تاثیر آن می تواند فوق العاده باشد.

بائر به TNW گفت: «به جای صدها تصمیم فردی که در جهت منافع شخصی گرفته می شود، نتایج ما نشان می دهد که GPT رانندگان را به شیوه ای هماهنگ تر و هماهنگ تر راهنمایی می کند و کارایی کلی سیستم ترافیک را در اولویت قرار می دهد.

“مسیرها نه تنها بر اساس سریع ترین گزینه برای یک خودرو، بلکه جریان بهینه برای همه خودروها پیشنهاد می شوند. نتیجه می تواند ترافیک کمتر، کاهش زمان رفت و آمد و یک محیط رانندگی هماهنگ تر باشد.”

بائر پتانسیل مشابهی را در مصرف انرژی می بیند. او جامعه ای را پیش بینی می کند که در آن هر خانواده می تواند از پنل های خورشیدی و باتری ها برای تولید، ذخیره و مصرف انرژی استفاده کند. چالش بهینه سازی مصرف آنها در ساعات اوج مصرف است.

باز هم، این سناریو شبیه به معضل زندانی است: صرفه جویی در انرژی برای استفاده صرفا شخصی در زمان تقاضای بالا یا کمک آن به شبکه برای ثبات کلی. هوش مصنوعی می تواند یک نتیجه بهینه دیگر را ارائه دهد.

بائر گفت: «به جای اینکه خانواده ها صرفاً برای منافع شخصی تصمیم بگیرند، سیستم توزیع انرژی را با در نظر گرفتن رفاه کل شبکه مدیریت می کند.

این به معنای هماهنگی ذخیرهسازی، مصرف و اشتراک انرژی بهگونهای است که از خاموشیها جلوگیری میکند و استفاده کارآمد از منابع را برای کل جامعه تضمین میکند که منجر به ایجاد یک شبکه انرژی پایدار، کارآمد و انعطافپذیر برای همه میشود.»

تضمین همکاری ایمن

همانطور که هوش مصنوعی به طور فزاینده ای در جامعه انسانی ادغام می شود، مدل های زیربنایی به راهنمایی نیاز دارند تا اطمینان حاصل شود که در خدمت اصول و اهداف ما هستند.

برای انجام این کار، بائر شفافیت گسترده در فرآیند تصمیم گیری و آموزش در مورد استفاده موثر را توصیه می کند.

او همچنین به شدت توصیه می کند که ارزش های سیستم هوش مصنوعی نظارت دقیق داشته باشد. را او میگوید، مانند GPT، صرفاً دادهها را محاسبه و پردازش نمیکنند، بلکه جنبههایی از طبیعت انسان را نیز اتخاذ میکنند. اینها ممکن است اکتسابی باشند در طول یادگیری خود نظارتی، پردازش داده یا بازخورد انسان به مدل.

گاهی اوقات، نتایج نگران کننده است. در حالی که GPT بیشتر از انسان ها در معضل زندانی همکاری می کرد، هنوز هم بازدهی خود را نسبت به سایر بازیکنان در اولویت قرار می داد. محققان گمان می کنند که این رفتار با ترکیبی از «عقلانیت بیش از حد» و «حفظ خود» هدایت می شود.

بائر گفت: «این بیش از حد عقلانیت بر نیاز ضروری به دستورالعملهای اخلاقی تعریفشده و شیوههای استقرار مسئولانه هوش مصنوعی تأکید میکند.

غریزه های بی بند و باری برای حفظ خود در هوش مصنوعی ممکن است چالش های اجتماعی ایجاد کند، به ویژه در سناریوهایی که تمایلات حفظ خود هوش مصنوعی به طور بالقوه می تواند با رفاه انسان ها در تضاد باشد.

منبع: https://thenextweb.com/news/prisoners-dilemma-ai-more-cooperative-humans